Najlepsze praktyki w Kubernetes. - Liz Rice, Brenda Burns, Eddie Villalba

advertisement

Brendan Burns, Eddie Villalba,

Dave Strebel, Lachlan Evenson

Najlepsze praktyki w

Kubernetes

Jak budować udane aplikacje

Tytuł oryginału: Kubernetes Best Practices: Blueprints for Building Successful Applications on

Kubernetes

Tłumaczenie: Robert Górczyński

ISBN: 978-83-283-7233-7

© 2021 Helion SA Authorized Polish translation of the English edition of Kubernetes Best

Practices ISBN 9781492056478 © 2020 Brendan Burns, Eddie Villalba, Dave Strebel, and

Lachlan Evenson

This translation is published and sold by permission of O’Reilly Media, Inc., which owns or

controls all rights to publish and sell the same.

All rights reserved. No part of this book may be reproduced or transmitted in any form or by

any means, electronic or mechanical, including photocopying, recording or by any information

storage retrieval system, without permission from the Publisher.

Wszelkie prawa zastrzeżone. Nieautoryzowane rozpowszechnianie całości lub fragmentu

niniejszej publikacji w jakiejkolwiek postaci jest zabronione. Wykonywanie kopii metodą

kserograficzną, fotograficzną, a także kopiowanie książki na nośniku filmowym, magnetycznym

lub innym powoduje naruszenie praw autorskich niniejszej publikacji.

Wszystkie znaki występujące w tekście są zastrzeżonymi znakami firmowymi bądź towarowymi

ich właścicieli.

Autorzy oraz Helion SA dołożyli wszelkich starań, by zawarte w tej książce informacje były

kompletne i rzetelne. Nie biorą jednak żadnej odpowiedzialności ani za ich wykorzystanie, ani

za związane z tym ewentualne naruszenie praw patentowych lub autorskich. Autorzy oraz

Helion SA nie ponoszą również żadnej odpowiedzialności za ewentualne szkody wynikłe z

wykorzystania informacji zawartych w książce.

HELION SA

ul. Kościuszki 1c, 44-100 GLIWICE

tel. 32 231 22 19, 32 230 98 63

e-mail: helion@helion.pl

WWW: http://helion.pl (księgarnia internetowa, katalog książek)

Drogi Czytelniku!

Jeżeli chcesz ocenić tę książkę, zajrzyj pod adres

http://helion.pl/user/opinie/naprak_ebook

Możesz tam wpisać swoje uwagi, spostrzeżenia, recenzję.

Pliki

z

przykładami

omawianymi

ftp://ftp.helion.pl/przyklady/naprak.zip

Poleć książkę

Kup w wersji papierowej

Oceń książkę

Księgarnia internetowa

Lubię to! » nasza społeczność

w

książce

można

znaleźć

pod

adresem:

Wprowadzenie

Dla kogo jest przeznaczona ta książka?

Kubernetes to faktycznie standard wdrożenia natywnej chmury. To narzędzie o potężnych

możliwościach, dzięki któremu Twoja następna aplikacja może być łatwiejsza do opracowania,

szybsza do wdrożenia i bardziej niezawodna w działaniu. Jednak żeby móc wykorzystać potężne

możliwości Kubernetes, trzeba używać go właściwie. Niniejsza książka jest przeznaczona dla

każdego, kto zajmuje się wdrażaniem rzeczywistych aplikacji w Kubernetes oraz jest

zainteresowany poznaniem wzorców i najlepszych praktyk, które mogą być zastosowane w

aplikacjach budowanych na podstawie Kubernetes.

Należy w tym miejscu wspomnieć, że ta książka nie zawiera informacji wprowadzających do

pracy z Kubernetes. Przyjęliśmy założenie, że znasz API i narzędzia Kubernetes, a także wiesz,

jak utworzyć klaster Kubernetes i z nim pracować. Jeżeli szukasz informacji pomagających w

rozpoczęciu pracy z Kubernetes, znajdziesz wiele dobrych pozycji na ten temat, np. Kubernetes.

Tworzenie niezawodnych systemów rozproszonych. Wydanie II (helion.pl/ksiazki/kuber2.htm).

Niniejsza książka została napisana dla czytelników, którzy chcą się zagłębić w temat wdrażania

określonych aplikacji i rozwiązań w Kubernetes. Powinna być użyteczna niezależnie od tego,

czy dopiero przystępujesz do wdrożenia pierwszej aplikacji w Kubernetes, czy też zajmujesz się

tym już od wielu lat.

Dlaczego napisaliśmy tę książkę?

Cała nasza czwórka ma duże doświadczenie w pomaganiu szerokiej gamie użytkowników we

wdrażaniu ich aplikacji w Kubernetes. Spotykaliśmy osoby zmagające się z wdrożeniem i

pomagaliśmy im znaleźć odpowiednie rozwiązania. W tej książce próbowaliśmy zawrzeć

wspomniane doświadczenie, aby jak najwięcej osób mogło uczyć się na naszych błędach, które

popełniliśmy w rzeczywistych wdrożeniach. Mamy nadzieję, że nasza wiedza zawarta w tej

książce pozwoli się skalować i że wykorzystasz ją do udanego wdrażania swoich aplikacji w

Kubernetes i zarządzania nimi.

Poruszanie się po książce

Wprawdzie tę książkę można przeczytać od deski do deski, ale tak naprawdę to nie będzie

właściwe podejście. Została zaprojektowana jako kolekcja oddzielnych rozdziałów. W każdym z

nich znajdziesz pełne omówienie określonego zadania, które być może będziesz chciał wykonać

za pomocą Kubernetes. Spodziewamy się, że zagłębisz się w lekturę, aby dokładnie poznać

interesujące Cię zagadnienie. Następnie odłożysz książkę na półkę i powrócisz do niej, gdy

pojawi się następny temat, który będziesz chciał poznać.

Mimo że przyjęliśmy podejście oparte na oddzielnych rozdziałach, pewne tematy przewijają się

w całej książce. Jest kilka rozdziałów poświęconych opracowywaniu aplikacji w Kubernetes. W

rozdziale 2. został omówiony sposób pracy programisty. W rozdziale 6. poruszamy temat ciągłej

integracji i testowania. W rozdziale 15. dowiesz się nieco o budowie platform wysokiego

poziomu na podstawie Kubernetes, a w rozdziale 16. zajmiemy się zarządzaniem informacjami o

stanie aplikacji. W kilku rozdziałach obok tematu opracowywania aplikacji zostały poruszone

zagadnienia związane z działaniem usług w Kubernetes. W rozdziale 1. przedstawiliśmy

konfigurację podstawowej usługi, a w rozdziale 3. — monitorowanie i sprawdzanie wskaźników.

W rozdziale 4. został poruszony temat zarządzania konfiguracją, rozdział 6. zaś dotyczy

wersjonowania i wydań. Z kolei z rozdziału 7. dowiesz się, jak można wdrożyć aplikację na

całym świecie.

W książce znalazło się kilka rozdziałów dotyczących zarządzania klastrem, m.in. rozdział 8.,

poświęcony zarządzaniu zasobami, rozdział 9., poświęcony sieci, rozdział 10., poświęcony

zapewnieniu bezpieczeństwa podom, rozdział 11., poświęcony polityce bezpieczeństwa i

zaleceniom, rozdział 12., poświęcony zarządzaniu wieloma klastrami, i rozdział 17., dotyczący

autoryzacji i sterowania dopuszczeniem do klastra. Ponadto mamy dwa prawdziwie niezależne

rozdziały. Pierwszy z nich (rozdział 14.) dotyczy uczenia maszynowego, a drugi (rozdział 13.) —

integracji z usługami zewnętrznymi.

Wprawdzie dobrym pomysłem może być przeczytanie wszystkich rozdziałów przed próbą

zajęcia się danym tematem w rzeczywistym projekcie, ale naszym celem było przygotowanie

książki, którą można traktować jako przewodnik. Ma ona pomóc w praktycznym zastosowaniu

omówionych tematów.

Konwencje zastosowane w książce

W tej książce zastosowano następujące konwencje typograficzne.

Kursywa

Wskazuje na nowe pojęcia, adresy URL i e-mail, nazwy plików, rozszerzenia plików itd.

Czcionka o stałej szerokości

Użyta w przykładowych fragmentach kodu, a także w samym tekście, w odwołaniach do

pewnych poleceń bądź innych elementów programistycznych, takich jak: nazwy zmiennych

lub funkcji, baz danych, typów danych, zmiennych środowiskowych, poleceń i słów

kluczowych.

Pogrubiona czcionka o stałej szerokości

Użyta w celu wyeksponowania poleceń bądź innego tekstu, który powinien być

wprowadzony przez czytelnika.

Pochylona czcionka o stałej szerokości

Wskazuje tekst, który powinien być zastąpiony wartościami podanymi przez użytkownika

bądź wynikającymi z kontekstu.

Taka ikona oznacza wskazówkę lub sugestię.

Taka ikona oznacza ogólną uwagę.

Taka ikona oznacza ostrzeżenie.

Użycie przykładowych kodów

Materiały dodatkowe (przykładowe fragmenty kodu, ćwiczenia itd.) zostały zamieszczone w

serwisie GitHub pod adresem https://github.com/brendandburns/kbp-sample.

Jeżeli masz pytania techniczne lub jakikolwiek problem związany z użyciem przykładowych

fragmentów kodu, możesz do nas napisać na adres bookquestions@oreilly.com.

Książka ta ma pomóc Ci w pracy. Ogólnie rzecz biorąc, można wykorzystywać zawarte w niej

przykłady w swoich programach i w dokumentacji. Nie trzeba kontaktować się z nami w celu

uzyskania zezwolenia, dopóki nie powiela się znaczących ilości kodu. Na przykład pisanie

programu, w którym znajdzie się kilka fragmentów kodu z tej książki, nie wymaga zezwolenia,

jednak sprzedawanie lub rozpowszechnianie płyty CD-ROM zawierającej przykłady z książki

wydawnictwa O’Reilly — już tak. Odpowiedź na pytanie przez cytowanie tej książki lub

przykładowego kodu nie wymaga zezwolenia, ale włączenie wielu przykładowych kodów z tej

książki do dokumentacji produktu czytelnika — już tak.

Jesteśmy wdzięczni za umieszczanie przypisów, ale nie wymagamy tego. Przypis zwykle zawiera

tytuł, autora, wydawcę i ISBN. Na przykład: Brendan Burns, Eddie Villalba, Dave Strebel i

Lachlan Evenson, Najlepsze praktyki w Kubernetes, ISBN 978-83-283-7232-0, Helion, Gliwice

2020.

Podziękowania

Brendan chciałby podziękować swojej wspaniałej rodzinie — Robin, Julii i Ethanowi — za miłość

i wsparcie, które otrzymuje na każdym kroku. Dziękuje także społeczności Kubernetes oraz

wspaniałym współautorom, bez których ta książka by nie powstała.

Dave chciałby podziękować swojej pięknej żonie Jen i trójce dzieci — Maxowi, Maddie i

Masonowi — za okazywane przez nich wsparcie. Dziękuje również społeczności Kubernetes za

wskazówki i pomoc, które otrzymał w ciągu wielu lat. Podziękowania składa także

współautorom, dzięki którym możliwe było powstanie tej książki.

Lachlan chciałby podziękować swojej żonie i trójce dzieci za miłość i wsparcie. Dziękuje

również każdemu członkowi społeczności Kubernetes, m.in. wspaniałym osobom, które przez

lata poświęciły swój czas, aby mu pomagać. Specjalne podziękowania kieruje do Josepha

Sandovala. Dziękuje także fantastycznym współautorom, dzięki którym możliwe było powstanie

tej książki.

Eddie chciałby podziękować swojej żonie Sandrze, za wsparcie i zgodę na to, aby znikał na całe

godziny, by pisać tę książkę w czasie, gdy ona była w ostatnim trymestrze ich pierwszej ciąży.

Chciałby też podziękować swojej córce Giavannie, za motywację do dalszego działania. Dziękuje

także społeczności Kubernetes oraz współautorom, którzy zawsze byli jego drogowskazami

podczas podróży do natywnej chmury.

Wszyscy chcielibyśmy podziękować Virginii Wilson za pracę nad tekstem oraz pomoc w

połączeniu wszystkich naszych pomysłów w jedną całość. Podziękowania składamy także innym

pracownikom wydawnictwa — Bridget Kromhout, Bilginowi Ibryamowi, Rolandowi Hußowi i

Justinowi Domingusowi — za ich zaangażowanie w dopracowanie szczegółów.

Rozdział 1. Konfiguracja

podstawowej usługi

W tym rozdziale zostaną przedstawione praktyki związane z konfiguracją wielowarstwowej

aplikacji w Kubernetes. Omawiane rozwiązanie składa się z prostej aplikacji internetowej i bazy

danych. Wprawdzie to nie jest zbyt skomplikowany przykład, ale doskonale nadaje się do

omówienia tematu zarządzania aplikacją w Kubernetes.

Ogólne omówienie aplikacji

Aplikacja, która zostanie użyta w omawianym przykładzie, nie zalicza się do szczególnie

skomplikowanych. To jest prosta usługa dziennika, przechowująca dane w backendzie opartym

na Redis. W aplikacji znajduje się oddzielny, statyczny plik serwera NGINX. W pojedynczym

adresie URL zostaną udostępnione dwie ścieżki internetowe. Jedna z nich jest przeznaczona dla

interfejsu API RESTful aplikacji (https://my-host.io/api), druga zaś to plik serwera dostępnego

pod głównym adresem URL (https://my-host.io/). Do zarządzania certyfikatami SSL (ang. secure

socket layer) została użyta usługa Let’s Encrypt (https://letsencrypt.org/). Omawiana aplikacja

została pokazana na rysunku 1.1. W rozdziale zajmiemy się jej budową: najpierw utworzymy

pliki konfiguracyjne YAML, a następnie pliki Helm w formacie chart1.

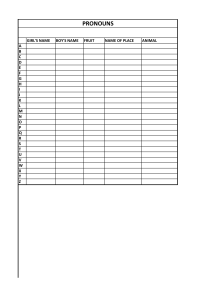

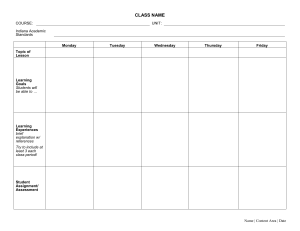

Rysunek 1.1. Wykres przedstawiający omawianą aplikację

Zarządzanie plikami konfiguracyjnymi

Zanim zagłębimy się w szczegóły związane z przygotowaniem tej aplikacji w Kubernetes, warto

zająć się tematem zarządzania plikami konfiguracyjnymi. W Kubernetes wszystko jest

przedstawiane w sposób deklaratywny. To oznacza możliwość zapisania oczekiwanego stanu

aplikacji w klastrze (ogólnie rzecz biorąc, te informacje umieszcza się w plikach typu YAML lub

JSON), a zadeklarowany stan będzie definiował wszystkie aspekty aplikacji. Takie deklaratywne

podejście jest znacznie chętniej stosowane niż podejście imperatywne, w którym aktualny stan

klastra jest wynikiem serii wprowadzonych w nim zmian. Jeżeli klaster jest definiowany

imperatywnie, wówczas bardzo trudno będzie replikować klaster do tego stanu. W takich

przypadkach niezwykle trudno jest dokładnie zrozumieć sposób funkcjonowania danego klastra

lub go naprawić po wystąpieniu problemów związanych z aplikacją.

Użytkownicy do deklarowania stanu aplikacji zwykle preferują pliki w formacie YAML lub JSON.

Kubernetes obsługuje oba wymienione typy. Warto wiedzieć, że format YAML jest zwięźlejszy i

łatwiejszy do edycji przez człowieka niż format JSON. Trzeba jednak w tym miejscu podkreślić,

że w formacie YAML wcięcia mają znaczenie. Część błędów w konfiguracjach Kubernetes

wynika z użycia niepoprawnych wcięć w pliku YAML. Jeżeli rozwiązanie nie działa zgodnie z

oczekiwaniami, wówczas procedurę debugowania najlepiej jest zacząć od sprawdzenia wcięć w

pliku konfiguracyjnym w formacie YAML.

Skoro deklaracyjny stan zapisany w plikach YAML działa w charakterze źródła danych o

aplikacji, to właściwe zarządzanie tymi informacjami o stanie ma krytyczne znaczenie dla

poprawności działania aplikacji. Podczas modyfikowania żądanego stanu aplikacji chcesz mieć

możliwość zarządzania zmianami, weryfikowania ich poprawności, sprawdzania, kto

wprowadził daną zmianę, i prawdopodobnie możliwość jej wycofania, gdy zmiana prowadzi do

niepoprawnego działania aplikacji. Na szczęście zostały opracowane narzędzia niezbędne do

zarządzania zmianami zapisanymi w postaci deklaratywnej oraz przeprowadzania audytu i

wycofywania zmian. Najlepsze praktyki w zakresie kontroli wersji i technik przeglądu kodu

(ang. code review) można bezpośrednio stosować podczas zarządzania deklaratywnym stanem

aplikacji.

Obecnie większość użytkowników przechowuje konfigurację Kubernetes w repozytoriach Git.

Wprawdzie szczegóły związane z systemem kontroli wersji nie mają znaczenia, ale wiele

narzędzi używanych w ekosystemie Kubernetes oczekuje plików znajdujących się w

repozytorium Git. Do przeglądu kodu używa się większej liczby narzędzi, choć GitHub jest

chętnie wykorzystywany także do tego celu. Do układania poszczególnych komponentów w

systemie plików warto stosować rozwiązanie oparte na katalogach systemu plików. Niezależnie

od sposobu implementacji technik przeglądu kodu w konfiguracji aplikacji do tego zadania

powinieneś podejść równie starannie i skoncentrować się nad tym, co dodajesz do kodu

źródłowego.

Do układania poszczególnych komponentów w systemie plików warto stosować rozwiązanie

oparte na katalogach systemu plików. Zwykle jeden katalog zawiera całą usługę aplikacji,

niezależnie od definicji usługi aplikacji stosowanej przez dany zespół. W tym katalogu znajdują

się podkatalogi zawierające podkomponenty aplikacji.

W przypadku omawianej aplikacji układ plików i katalogów wygląda tak:

journal/

frontend/

redis/

fileserver/

W poszczególnych katalogach znajdują się konkretne pliki YAML potrzebne do zdefiniowania

usługi. Jak zobaczysz w dalszej części rozdziału, gdy rozpoczniesz wdrażanie aplikacji w wielu

różnych regionach lub klastrach, ten układ plików i katalogów stanie się znacznie bardziej

skomplikowany.

Tworzenie usługi replikowanej za pomocą

wdrożeń

Aby opracować aplikację, rozpoczynamy od frontendu, a następnie zajmujemy się kolejnymi

komponentami. W omawianym przykładzie frontendem jest aplikacja Node.js, której kod został

utworzony w języku TypeScript. Pełna aplikacja (https://github.com/brendandburns/kbpsample) jest zbyt obszerna, aby jej kod w całości zamieścić w książce. Udostępnia ona na porcie

8080 usługę HTTP, która obsługuje żądania kierowane do ścieżki dostępu /api/∗, i używa

opartego na Redis backendu w celu dodania, usunięcia lub przekazania aktualnych wpisów

dziennika. Tę aplikację można umieścić w obrazie kontenera za pomocą dołączonego pliku

Dockerfile, a następnie przekazać ten obraz do własnego repozytorium obrazów. Jeżeli

zdecydujesz się na takie rozwiązanie, pamiętaj, aby w kolejnych przykładach plików

konfiguracyjnych YAML zamieniać użytą nazwę na nazwę utworzonego obrazu.

Najlepsze praktyki dotyczące zarządzania obrazami

kontenera

Choć tworzenie obrazów kontenera i zarządzanie nimi wykracza poza zakres tematyczny tej

książki, warto wspomnieć o kilku najlepszych podstawowych praktykach stosowanych podczas

tworzenia obrazów i nadawania im nazw. Ogólnie rzecz biorąc, proces tworzenia obrazu może

być podatny na ataki przeprowadzane na „łańcuch dostawców”. W trakcie takiego ataku

przeprowadzająca go osoba wstrzykuje kod lub pliki binarne do pewnej i pochodzącej z

zaufanego źródła zależności, która następnie zostaje wbudowana w aplikację. Z powodu

niebezpieczeństwa takich ataków krytyczne znaczenie podczas tworzenia obrazów ma

opieranie ich na doskonale znanych i w pełni zaufanych dostawcach obrazów. Ewentualnie

wszystko możesz zbudować od zera. To drugie rozwiązanie jest łatwe w przypadku niektórych

języków programowania (np. Go), które pozwalają na tworzenie statycznych plików binarnych.

Okazuje się jednak znacznie bardziej skomplikowane w przypadku języków interpretowanych,

takich jak Python, JavaScript i Ruby.

Następna najlepsza praktyka dotycząca obrazów jest związana z nadawaniem im nazw. Choć

wersja obrazu kontenera w rejestrze obrazów teoretycznie jest modyfikowalna, tag wersji

powinien być traktowany jako niemodyfikowalny. W szczególności dobrą praktyką w nadawaniu

nazw obrazom jest połączenie wersji semantycznej i wartości hash SHA operacji zatwierdzenia,

w trakcie której został utworzony obraz (np. v1.0.1-bfeda01f). Jeżeli nie podasz wersji obrazu,

domyślnie zostanie użyta wartość latest. Wprawdzie to może być wygodne rozwiązanie

podczas pracy nad rozwiązaniem, ale jest kiepskim pomysłem w środowisku produkcyjnym,

ponieważ wersja oznaczona jako latest niewątpliwie będzie modyfikowana w trakcie każdej

operacji tworzenia nowego obrazu.

Tworzenie replikowanej aplikacji

W omawianym przykładzie aplikacja frontendu jest bezstanowa i całkowicie opiera się na

backendzie Redis w zakresie informacji o stanie. Dlatego też można dowolnie ją replikować bez

wpływu na ruch sieciowy. Wprawdzie prawdopodobieństwo, że ta aplikacja nadaje się do użycia

na ogromną skalę, jest znikome, ale jest wystarczająco dobra do działania w co najmniej dwóch

replikach. W takim przypadku zarówno nieoczekiwana awaria aplikacji, jak i wdrożenie jej

nowej wersji nie muszą powodować przestoju w jej działaniu.

W Kubernetes ReplicaSet to zasób pozwalający na zarządzanie replikacją aplikacji

umieszczonej w kontenerze, więc bezpośrednie używanie tego zasobu nie jest najlepszą

praktyką. Zamiast tego należy skorzystać z zasobu o nazwie Deployment. Stanowi on rodzaj

połączenia oferowanych przez ReplicaSet możliwości replikacji z wersjonowaniem i zdolnością

do wprowadzania zmian etapami. Dzięki wykorzystaniu zasobu Deployment można użyć

wbudowanych w Kubernetes narzędzi do przejścia z jednej wersji aplikacji do drugiej.

Spójrz na kod zasobu Deployment w naszej aplikacji.

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

labels:

app: frontend

name: frontend

namespace: default

spec:

replicas: 2

selector:

matchLabels:

app: frontend

template:

metadata:

labels:

app: frontend

spec:

containers:

- image: my-repo/journal-server:v1-abcde

imagePullPolicy: IfNotPresent

name: frontend

resources:

request:

cpu: "1.0"

memory: "1G"

limits:

cpu: "1.0"

memory: "1G"

Trzeba zwrócić uwagę na kilka kwestii dotyczących przedstawionego tutaj zasobu Deployment.

Przede wszystkim używamy etykiet do identyfikacji zasobów Deployment i ReplicaSet oraz

podów tworzonych przez zasób Deployment. Do wszystkich zasobów została dodana etykieta

layer: frontend, aby można było je analizować dla konkretnej warstwy w pojedynczym

żądaniu. W trakcie pracy przekonasz się, że podczas dodawania innych zasobów stosowana jest

dokładnie ta sama praktyka.

Dodatkowo w wielu miejscach pliku YAML dodaliśmy komentarze. Wprawdzie nie trafiają one

do zasobu Kubernetes przechowywanego w serwerze i są jedynie komentarzami do kodu, ale

mają pomóc osobom, które po raz pierwszy mają styczność z daną konfiguracją.

Powinieneś również zwrócić uwagę na to, że dla zasobu Deployment zostały zdefiniowane

żądania zasobów Request i Linit, a wartość Request jest równa wartości Limit. Podczas

działania aplikacji Request to miejsce zarezerwowane, którego wartością będzie nazwa hosta

zawierającego uruchomioną aplikację. Z kolei Limit określa maksymalną ilość zasobów, które

mogą być użyte przez dany kontener. Gdy uruchamiasz aplikację, przypisanie Request wartości

Limit zapewnia najbardziej przewidywalne zachowanie aplikacji. Ta przewidywalność odbywa

się za cenę większego użycia zasobów. Skoro przypisanie Request wartości Limit uniemożliwia

aplikacji nadmierne wykorzystanie dostępnych zasobów, nie będziesz miał możliwości użyć ich

w pełni aż do chwili, gdy niezwykle starannie dopasujesz wartości Request i Limit. Gdy

staniesz się bardziej zaawansowany w zakresie modelu zasobów Kubernetes, możesz rozważyć

niezależne modyfikowanie wartości Request i Limit w aplikacji. Jednak dla większości

użytkowników stabilizacja wynikająca z przewidywalności jest warta mniejszego poziomu

wykorzystania zasobów.

Po zdefiniowaniu zasobu Deployment można go przekazać do systemu kontroli wersji i wdrożyć

w Kubernetes.

$ git add frontend/deployment.yaml

$ git commit -m "Zdefiniowanie zasobu Deployment" frontend/deployment.yaml

$ kubectl apply -f frontend/deployment.yaml

Najlepszą praktyką jest również zagwarantowanie, że zawartość klastra dokładnie odpowiada

stanowi zdefiniowanemu w systemie kontroli wersji. Najlepszym wzorcem pozwalającym na

spełnienie tego warunku jest zaadaptowanie podejścia GitOps i wdrażanie do środowiska

produkcyjnego tylko kodu z określonych gałęzi systemu kontroli wersji z użyciem automatyzacji

w postaci ciągłej integracji (ang. continuous integration, CI) i ciągłego wdrażania (ang.

continuous delivery, CD). W ten sposób będziesz miał gwarancję zachowania spójności między

stanem aplikacji w środowisku produkcyjnym a jej stanem zdefiniowanym w systemie kontroli

wersji. Choć pełne rozwiązanie oparte na technikach CI/CD wydaje się przesadą w przypadku

tak prostej aplikacji, ale automatyzacja sama w sobie, niezależnie od niezawodności, jaką

zapewnia, zwykle jest warta wysiłku związanego z jej przygotowaniem. Warto w tym miejscu

dodać, że implementacja technik ciągłej integracji i ciągłego wdrażania dla już istniejącej i

wdrożonej aplikacji jest wyjątkowo trudnym zadaniem.

Pozostało jeszcze do omówienia kilka fragmentów tego pliku YAML opisującego aplikację (np.

zasoby ConfigMap, ukryte woluminy, a także kwestie związane z jakością usługi poda). Zrobimy

to dokładniej w dalszej części rozdziału.

Konfiguracja zewnętrznego

przychodzącego ruchu sieciowego HTTP

Kontener naszej przykładowej aplikacji został wdrożony, ale obecnie jeszcze nikt nie może

uzyskać do niej dostępu. Domyślnie zasoby klastra są dostępne jedynie dla użytkowników

danego klastra. Aby publicznie udostępnić aplikację, trzeba utworzyć usługę i mechanizm

równoważenia obciążenia w celu zdefiniowania zdalnego adresu IP, poprzez który kontener

będzie mógł otrzymywać ruch sieciowy. Udostępnianie kontenera na zewnątrz będzie się

odbywało za pomocą dwóch zasobów Kubernetes. Pierwszym jest usługa działająca w

charakterze mechanizmu równoważenia obciążenia dla ruchu sieciowego TCP (ang.

transmission control protocol) i UDP (ang. user datagram protocol). W omawianym przykładzie

jest wykorzystywany protokół TCP. Drugim jest zasób Ingress zapewniający mechanizm

równoważenia obciążenia HTTP(S), który stosuje sprytnie działający routing żądań na

podstawie ścieżek HTTP i nazw hostów. W przypadku tak prostej aplikacji jak omawiana być

może się zastanawiasz, dlaczego zdecydowaliśmy się na użycie tak złożonego zasobu Ingress.

Jak się przekonasz w dalszej części rozdziału, nawet ta prosta aplikacja będzie obsługiwała

żądania HTTP pochodzące z dwóch różnych usług. Co więcej, zdefiniowanie brzegowego zasobu

Ingress zapewnia elastyczność późniejszej rozbudowy usługi.

Zanim będzie można zdefiniować zasób Ingress, potrzebna jest Kubernetes usługa (zasób

Service), do której wymieniony zasób będzie prowadził. Etykiety wykorzystamy w celu

przekierowania usługi do podów utworzonych we wcześniejszej części rozdziału. Zasób Service

jest znacznie prostszy do zdefiniowania niż Deployment i przedstawia się następująco:

apiVersion: v1

kind: Service

metadata:

labels:

app: frontend

name: frontend

namespace: default

spec:

ports:

- port: 8080

protocol: TCP

targetPort: 8080

selector:

app: frontend

type: ClusterIP

Po zdefiniowaniu zasobu Service można przystąpić do zdefiniowania zasobu Ingress. W

przeciwieństwie do zasobu Service zasób Ingress wymaga działającego w klastrze kontenera

kontrolera. Do dyspozycji masz wiele różnych implementacji, z których możesz wybierać: od

oferowanych przez dostawców chmury po implementacje serwerów typu open source. Jeżeli

zdecydujesz się na instalację zasobu Ingress na podstawie dostawcy oprogramowania typu

open source, dobrym rozwiązaniem będzie skorzystanie z menedżera pakietów Helm

(https://helm.sh/) do zainstalowania oprogramowania i zarządzania nim. Do popularnych

rozwiązań zaliczają się dostawcy Ingress o nazwach nginx i haproxy.

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: frontend-ingress

spec:

rules:

- http:

paths:

- path: /api

backend:

serviceName: frontend

servicePort: 8080

Konfigurowanie aplikacji za pomocą

zasobu ConfigMap

Każda aplikacja wymaga pewnej konfiguracji. W omawianym przykładzie to może być liczba

wpisów dziennika wyświetlanych na stronie, kolor określonego tła, definicja specjalnego

komunikatu wyświetlanego w okresie świątecznym lub dowolny inny rodzaj konfiguracji.

Zwykle oddzielenie takich informacji konfiguracyjnych od samej aplikacji to jedna z najlepszych

praktyk.

Jest kilka różnych powodów do stosowania wspomnianej separacji. Przede wszystkim być może

będziesz chciał skonfigurować ten sam plik binarny aplikacji, ale z odmienną konfiguracją, w

zależności od ustawień. Przykładowo w Europie być może będziesz chciał uczcić Wielkanoc,

podczas gdy w Chinach zechcesz przygotować coś specjalnego na chiński Nowy Rok. Poza taką

specjalizacją środowiskową mamy jeszcze wiele innych powodów do stosowania separacji. Pliki

binarne zwykle zawierają wiele różnych, nowych funkcjonalności. Jeżeli włączysz je w kodzie,

wówczas jedynym sposobem na modyfikację aktywnych funkcjonalności będzie skompilowanie i

utworzenie nowego pliku binarnego, co może być kosztownym i wolnym procesem.

Użycie konfiguracji do aktywacji zestawu funkcjonalności oznacza możliwość szybkiego (i

nawet dynamicznego) aktywowania oraz dezaktywowania funkcjonalności w odpowiedzi na

potrzeby użytkownika lub awarie kodu aplikacji. Funkcjonalności mogą być włączane i

wyłączane pojedynczo. Taka elastyczność gwarantuje nieustanny postęp w większości

funkcjonalności, nawet jeśli część z nich będzie musiała zostać wycofana w celu poprawy

wydajności działania lub usunięcia błędów.

W Kubernetes przykładem tego rodzaju konfiguracji jest zasób o nazwie ConfigMap. Zawiera on

wiele par klucz-wartość przedstawiających informacje konfiguracyjne lub plik. Te informacje

konfiguracyjne mogą być przekazane kontenerowi w podzie za pomocą plików lub zmiennych

środowiskowych. Wyobraź sobie, że chcesz skonfigurować aplikację dziennika internetowego w

taki sposób, aby wyświetlała możliwą do określenia liczbę wpisów na stronie. Aby osiągnąć ten

efekt, należy w pokazany tutaj sposób skonfigurować zasób ConfigMap.

$ kubectl create configmap frontend-config --from-literal=journalEntries=10

W celu skonfigurowania aplikacji informacje konfiguracyjne są przekazywane w postaci

zmiennej środowiskowej. W tym celu do zdefiniowanego wcześniej zasobu Deployment można

dodać przedstawiony tutaj zasób container.

...

# Tablica containers w PodTemplate w zasobie Deployment.

containers:

- name: frontend

...

env:

- name: JOURNAL_ENTRIES

valueFrom:

configMapKeyRef:

name: frontend-config

key: journalEntries

...

Wprawdzie ten przykład pokazuje, jak można używać zasobu ConfigMap do konfigurowania

aplikacji, ale w rzeczywistych wdrożeniach chcesz mieć możliwość regularnego wprowadzania

zmian w konfiguracji, np. co tydzień lub jeszcze częściej. Kusząca może być możliwość

wprowadzenia zmiany przez modyfikację samego zasobu ConfigMap, choć to nie jest najlepszą

praktyką. Powodów jest kilka. Jednym z nich jest to, że zmiana konfiguracji tak naprawdę nie

wywołuje uaktualnienia istniejących podów. Konfiguracja jest stosowana tylko podczas

ponownego uruchamiania poda. Dlatego też w takim przypadku wprowadzanie zmian nie

odbywa się na podstawie stanu poda i może nastąpić doraźnie lub przypadkowo.

Znacznie lepszym podejściem jest umieszczenie numeru wersji w nazwie zasobu ConfigMap.

Zamiast nazwy typu frontend-config można użyć frontend-config-v1. Gdy będziesz chciał

wprowadzić zmianę, to zamiast modyfikować istniejący zasób ConfigMap, powinieneś utworzyć

jego drugą wersję, a następnie uaktualnić zasób Deployment w celu użycia nowej wersji zasobu

ConfigMap. Gdy tak zrobisz, nastąpi automatyczne wywołanie wprowadzenia zmian zasobu

Deployment na podstawie odpowiedniej operacji sprawdzenia i zastosowanie pauzy między

zmianami. Co więcej, jeśli kiedykolwiek będziesz chciał powrócić do wcześniejszej wersji,

wiedz, że konfiguracja oznaczona jako v1 nadal pozostaje w klastrze, a wycofanie sprowadza się

do ponownego uaktualnienia zasobu Deployment.

Zarządzanie uwierzytelnianiem za

pomocą danych poufnych

Nawet nie zaczęliśmy omawiać usługi Redis, z którą jest połączony frontend aplikacji. Jednak w

każdej rzeczywistej aplikacji konieczne jest nawiązywanie bezpiecznych połączeń między

usługami. W tej części rozdziału zajmiemy się kwestiami bezpieczeństwa użytkowników i ich

danych. Ponadto bardzo duże znaczenie ma unikanie takich błędów jak nawiązanie połączenia

programistycznej wersji frontendu z produkcyjną wersją bazy danych.

Do uwierzytelniania bazy danych Redis jest używane zwykłe hasło. Za wygodne rozwiązanie

możesz uznać umieszczenie wspomnianego hasła w kodzie źródłowym aplikacji bądź też w pliku

znajdującym się w obrazie kontenera. Jednak oba te rozwiązania są naprawdę złe, i to z wielu

powodów. Przede wszystkim w ten sposób dane poufne (hasło) ujawniasz w środowisku, w

którym niekoniecznie masz kontrolę nad dostępem do danych. Jeżeli hasło zostanie

umieszczone w systemie kontroli wersji, w ten sposób każdemu, kto ma dostęp do kodu

źródłowego, zapewnisz również dostęp do wszystkich umieszczonych w nim danych poufnych.

To nie jest dobre rozwiązanie. Prawdopodobnie grono użytkowników z dostępem do kodu

źródłowego jest znacznie większe niż to, które powinno mieć dostęp do egzemplarza Redis.

Podobnie, jeśli użytkownik ma dostęp do obrazu kontenera, niekoniecznie powinien mieć dostęp

do produkcyjnej bazy danych.

Poza obawami związanymi z kontrolą dostępu powodem, dla którego lepiej unikać umieszczania

danych poufnych w kodzie źródłowym i/lub obrazach kontenera, jest parametryzacja. Zapewne

chcesz mieć możliwość wykorzystania tego samego kodu źródłowego i obrazów w różnych

środowiskach (np. programistycznym, kanarkowym i produkcyjnym). Jeżeli dane poufne będą

ściśle powiązane z kodem źródłowym lub obrazem, wówczas dla każdego z wymienionych

środowisk będzie potrzebny oddzielny obraz (lub kod źródłowy).

Skoro w poprzednim podrozdziale miałeś okazję zobaczyć zasób ConfigMap w akcji, być można

uważasz, że hasło można umieścić w konfiguracji, która następnie będzie przekazywana

aplikacji jako przygotowana specjalnie dla niej. Masz pełne prawo być przekonanym, że

odseparowanie konfiguracji od aplikacji jest tym samym, co oddzielenie od aplikacji danych

poufnych. Jednak trzeba w tym miejscu dodać, że dane poufne to koncepcja bardzo ważna sama

w sobie. Prawdopodobnie chcesz zająć się kontrolą dostępu do danych poufnych oraz ich

obsługą i uaktualnianiem nie poprzez konfigurację, ale w zdecydowanie inny sposób. Co

ważniejsze, chciałbyś skłonić programistów do innego sposobu myślenia podczas dostępu do

danych poufnych niż podczas dostępu do ustawień konfiguracyjnych. Dlatego też Kubernetes

ma wbudowany zasób o nazwie Secret, przeznaczony do zarządzania danymi poufnymi.

Utworzenie hasła dla bazy danych Redis może odbyć się tak:

$ kubectl create secret generic redis-passwd --from-literal=passwd=${RANDOM}

Oczywiście możesz zdecydować się na własne hasło zamiast losowo wybranej liczby. Ponadto

prawdopodobnie będziesz chciał używać usługi przeznaczonej do zarządzania hasłem,

oferowanej przez dostawcę chmury, np. Microsoft Azure Key Vault, lub w postaci projektu typu

open source, np. HashiCorp Vault. Gdy korzystasz z usługi zarządzania kluczami, zapewnia ona

ściślejszą integrację z zasobem Secrets w Kubernetes.

Dane poufne w Kubernetes są domyślnie przechowywane w postaci

niezaszyfrowanej. Jeżeli chcesz je przechowywać jako zaszyfrowane, możesz

zintegrować rozwiązanie z dostawcą kluczy, aby przekazać Kubernetes klucz

przeznaczony do odszyfrowania wszystkich danych poufnych znajdujących się w

klastrze. Zwróć uwagę na to, że to zabezpiecza klucze przed bezpośrednimi atakami

na bazę etcd; konieczne jest jeszcze właściwe zabezpieczenie dostępu za pomocą

API serwera Kubernetes.

Po umieszczeniu w Kubernetes hasła do bazy danych Redis konieczne jest dołączenie danych

poufnych do uruchomionej aplikacji po jej wdrożeniu w Kubernetes. W tym celu można

skorzystać z Kubernetes Volume, czyli pliku lub katalogu, który można zamontować w

działającym kontenerze, w miejscu wskazanym przez użytkownika. W przypadku danych

poufnych wolumin jest tworzony w pamięci RAM jako system plików tmpfs, a następnie

montowany w kontenerze. To gwarantuje, że nawet jeśli komputer zostanie fizycznie przejęty

(to w zasadzie niemożliwe w przypadku usług w chmurze, choć może się zdarzyć w fizycznie

istniejącym centrum danych), dane poufne nie będą łatwo dostępne dla osoby

przeprowadzającej atak.

Aby dodać wolumin z danymi poufnymi do zasobu Deployment, trzeba zdefiniować dwa nowe

polecenia w pliku YAML wymienionego zasobu. Pierwsze z nich to sekcja volumes dla poda

odpowiedzialnego za dodawanie woluminu do poda:

...

volumes:

- name: passwd-volume

secret:

secretName: redis-passwd

Gdy już wolumin znajduje się w podzie, następnym krokiem jest zamontowanie go w

określonym kontenerze. To się odbywa z użyciem właściwości zdefiniowanych w sekcji

volumeMounts w opisie kontenera.

...

volumeMounts:

- name: passwd-volume

readOnly: true

mountPath: "/etc/redis-passwd"

...

W ten sposób wolumin danych poufnych zostanie zamontowany w katalogu redis-passwd w celu

zapewnienia dostępu z poziomu kodu klienta. Po zebraniu wszystkiego w całość otrzymujemy

pełną konfigurację zasobu Deployment.

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

labels:

app: frontend

name: frontend

namespace: default

spec:

replicas: 2

selector:

matchLabels:

app: frontend

template:

metadata:

labels:

app: frontend

spec:

containers:

- image: my-repo/journal-server:v1-abcde

imagePullPolicy: IfNotPresent

name: frontend

volumeMounts:

- name: passwd-volume

readOnly: true

mountPath: "/etc/redis-passwd"

resources:

request:

cpu: "1.0"

memory: "1G"

limits:

cpu: "1.0"

memory: "1G"

volumes:

- name: passwd-volume

secret:

secretName: redis-passwd

Na tym etapie mamy skonfigurowaną aplikację klienta, która otrzymuje dostęp do danych

poufnych pozwalających na przeprowadzenie uwierzytelnienia w usłudze Redis. Konfiguracja

Redis do użycia hasła odbywa się podobnie: należy zamontować wolumin w podzie Redis, a

następnie odczytać hasło z pliku.

Wdrożenie prostej bezstanowej bazy

danych

Wprawdzie pod względem koncepcji wdrożenie aplikacji zawierającej informacje o stanie

odbywa się podobnie do wdrożenia klienta, takiego jak nasz frontend, ale konieczność

przechowywania informacji o stanie wiąże się z pewnymi komplikacjami. Przede wszystkim pod

w Kubernetes może być ponownie przydzielony z wielu powodów, takich jak sprawdzenie stanu,

uaktualnienie i ponowne równoważenie obciążenia. W takiej sytuacji pod może trafić do innego

komputera. Jeżeli dane powiązane z egzemplarzem Redis znajdują się w określonym

komputerze lub wewnątrz kontenera, wówczas zostaną utracone po przeprowadzeniu migracji

kontenera lub po jego ponownym uruchomieniu. Aby tego uniknąć, trzeba stosować zdalne

trwałe woluminy (API PersistentVolumes), przeznaczone do zarządzania informacjami o stanie

powiązanymi z aplikacją.

Istnieje wiele różnych implementacji trwałych woluminów w Kubernetes, przy czym wszystkie

współdzielą cechy charakterystyczne. Podobnie jak w przypadku danych poufnych, omówionych

we wcześniejszej części rozdziału, trwałe woluminy są powiązane z podem i montowane w

kontenerze, w określonym położeniu. Jednak w przeciwieństwie do danych poufnych trwałe

woluminy są, ogólnie rzecz biorąc, zdalnymi magazynami danych zamontowanymi poprzez

protokoły sieciowe, takie jak NFS (ang. network file system), SMB (ang. server message block)

lub oparty na blokach (iSCSI, dysk oparty na chmurze itd.). W przypadku aplikacji takich jak

bazy danych preferowane są dyski oparte na blokach, ponieważ zapewniają one większą

wydajność działania. Jeśli zaś wydajność działania nie ma znaczenia krytycznego, dyski oparte

na plikach mogą czasami zapewnić większą elastyczność.

Zarządzanie stanem jest ogólnie dość skomplikowanym zadaniem i Kubernetes nie

jest tutaj wyjątkiem. Jeżeli operujesz w środowisku obsługującym usługi z

informacjami o stanie (MySQL jako usługa, Redis jako usługa itd.), wówczas używanie

tych usług jest dobrym rozwiązaniem. Początkowo koszt usługi typu SaaS (ang.

software as a service) zapewniającej obsługę informacji o stanie może wydawać się

wysoki. Jednak po uwzględnieniu wszystkich operacyjnych wymagań w zakresie

obsługi informacji o stanie (kopia zapasowa, lokalność danych, nadmiarowość danych

itd.) i tego, że istnienie w klastrze Kubernetes informacji o stanie utrudnia

przenoszenie aplikacji między klastrami, okazuje się, że w większości przypadków

warto jest ponieść koszt związany z SaaS. W środowiskach nieoferujących SaaS

przygotowanie osobnego zespołu dostarczającego pamięć masową jako usługę dla

całej organizacji to zdecydowanie lepsza praktyka niż umożliwienie każdemu

zespołowi opracowania takiego rozwiązania samodzielnie.

W celu wdrożenia usługi Redis wykorzystamy zasób StatefulSet. Dodany po początkowym

wydaniu Kubernetes jako uzupełnienie zasobu ReplicaSet, StatefulSet zapewnia większe

gwarancje np. w zakresie spójności nazw (żadnych losowych wartości hash) i zdefiniowanej

kolejności podczas skalowania w górę i skalowania w dół. Gdy wdrażasz wzorzec singleton, to

będzie miało mniejsze znaczenie. Natomiast jeśli chcesz wdrożyć replikowane informacje o

stanie, wymienione atrybuty są bardzo wygodne.

W celu przygotowania trwałego woluminu dla naszej bazy Redis wykorzystamy zasób

PersistentVolumeClaim. Słowo claim (z ang. oświadczenie) w nazwie oznacza tutaj „żądanie

zasobu”. Nasza baza danych Redis deklaruje pamięć masową o wielkości 50 GB, a klaster

Kubernetes określa, jak przygotować odpowiedni trwały wolumin. Tak się dzieje z dwóch

powodów. Pierwszy to możliwość utworzenia zasobu StatefulSet w sposób zapewniający

możliwość przeniesienia między różnymi chmurami, w których szczegóły związane z

implementacją dysku mogą być odmienne. Drugi to możliwość użycia oświadczenia woluminu

do przeprowadzenia operacji zapisu w szablonie, który może być replikowany do

poszczególnych podów z przypisanymi trwałymi woluminami. Trzeba w tym miejscu dodać, że

wiele typów trwałego woluminu można montować w pojedynczym podzie.

W kolejnym fragmencie kodu pokazaliśmy przykład zasobu StatefulSet w akcji.

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: redis

spec:

serviceName: "redis"

replicas: 1

selector:

matchLabels:

app: redis

template:

metadata:

labels:

app: redis

spec:

containers:

- name: redis

image: redis:5-alpine

ports:

- containerPort: 6379

name: redis

volumeMounts:

- name: data

mountPath: /data

volumeClaimTemplates:

- metadata:

name: data

spec:

accessModes: [ "ReadWriteOnce" ]

resources:

requests:

storage: 10Gi

Ten kod spowoduje wdrożenie pojedynczego egzemplarza usługi Redis. Przyjmujemy założenie,

że chcemy replikować ten klaster Redis w celu skalowania operacji odczytu i zapewnienia

odporności na awarie. To oczywiście oznacza konieczność zwiększenia liczby replik do trzech, a

także zagwarantowania, że dwie nowe repliki nawiążą połączenie z serwerem głównym (ang.

master) dla Redis, aby przeprowadzać operacje zapisu.

Gdy definiujesz działającą w trybie headless usługę dla Redis zasobu StatefulSet, wówczas

następuje utworzenie wpisu DNS redis-0.redis. To jest adres IP pierwszej repliki. Tę wartość

można wykorzystać do utworzenia prostego skryptu, który będzie mógł zostać uruchomiony we

wszystkich kontenerach.

#!/bin/bash

PASSWORD=$(cat /etc/redis-passwd/passwd)

if [[ "${HOSTNAME}" == "redis-0" ]]; then

redis-server --requirepass ${PASSWORD}

else

redis-server --slaveof redis-0.redis 6379 --masterauth ${PASSWORD} -requirepass ${PASSWORD}

fi

Ten skrypt można utworzyć w postaci zasobu ConfigMap:

$ kubectl create configmap redis-config --from-file=launch.sh=launch.sh

Następnie można ten zasób ConfigMap dodać do zasobu StatefulSet i użyć go w charakterze

polecenia dla kontenera. Dodamy również hasło potrzebne podczas uwierzytelniania, które

zostało przygotowane nieco wcześniej w rozdziale.

Pełny kod zasobu dla trzech replik Redis jest następujący:

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: redis

spec:

serviceName: "redis"

replicas: 3

selector:

matchLabels:

app: redis

template:

metadata:

labels:

app: redis

spec:

containers:

- name: redis

image: redis:5-alpine

ports:

- containerPort: 6379

name: redis

volumeMounts:

- name: data

mountPath: /data

- name: script

mountPath: /script/launch.sh

subPath: launch.sh

- name: passwd-volume

mountPath: /etc/redis-passwd

command:

- sh

- -c

- /script/launch.sh

volumes:

- name: script

configMap:

name: redis-config

defaultMode: 0777

- name: passwd-volume

secret:

secretName: redis-passwd

volumeClaimTemplates:

- metadata:

name: data

spec:

accessModes: [ "ReadWriteOnce" ]

resources:

requests:

storage: 10Gi

Utworzenie za pomocą usług mechanizmu

równoważenia obciążenia TCP

Po wdrożeniu usługi Redis zawierającej informacje o stanie konieczne jest jej udostępnienie

naszemu frontendowi. W tym celu trzeba będzie utworzyć dwie odmienne usługi Kubernetes.

Zadaniem pierwszej jest odczytywanie danych z Redis. Skoro Redis przeprowadza replikację

danych do wszystkich trzech zasobów StatefulSet, zupełnie nas nie interesuje to, do którego z

serwerów zostanie wykonane żądanie odczytu. W efekcie korzystamy z bardzo prostej usługi

odczytu danych z Redis.

apiVersion: v1

kind: Service

metadata:

labels:

app: redis

name: redis

namespace: default

spec:

ports:

- port: 6379

protocol: TCP

targetPort: 6379

selector:

app: redis

sessionAffinity: None

type: ClusterIP

Aby przeprowadzić operacje zapisu, trzeba wskazać serwer główny w Redis (replika nr 0). W

tym celu należy utworzyć usługę działającą w trybie headless. Taka usługa nie ma adresu IP

klastra. Zamiast tego programuje wpis DNS dla każdego poda w zasobie StatefulSet. To

oznacza możliwość uzyskania dostępu do serwera głównego Redis za pomocą nazwy DNS

redis-0.redis.

apiVersion: v1

kind: Service

metadata:

labels:

app: redis-write

name: redis-write

spec:

clusterIP: None

ports:

- port: 6379

selector:

app: redis

Dlatego gdy chcesz nawiązać połączenie z bazą Redis w celu przeprowadzenia operacji zapisu

lub transakcyjnej pary operacji odczytu i zapisu, wówczas możesz utworzyć oddzielnego klienta

nawiązującego połączenie z serwerem redis-0.redis.

Przekazanie przychodzącego ruchu

sieciowego do serwera pliku statycznego

Ostatnim komponentem aplikacji jest serwer pliku statycznego. Ten serwer jest odpowiedzialny

za udostępnianie plików typu HTML, CSS, JavaScript i obrazów. W omawianym przykładzie

znacznie efektywniejszym i czytelniejszym rozwiązaniem będzie dla nas oddzielenie serwera

pliku statycznego od API obsługującego omówiony wcześniej frontend. Bardzo łatwo można

wykorzystać charakteryzujący się wysoką wydajnością działania serwer pliku statycznego, taki

jak NGINX, do obsługi wymienionych rodzajów plików i pozwolić zespołowi programistów

skoncentrować się na kodzie niezbędnym do implementacji API.

Na szczęście zasób Ingress niezwykle ułatwia stosowanie architektury minimikrousług.

Podobnie jak w przypadku frontendu zasób Deployment można wykorzystać do opisania

replikowanego serwera NGINX. Zajmiemy się umieszczeniem serwera NGINX w obrazie

kontenera i wdrożeniem go w każdej replice. Kod źródłowy zasobu Deployment jest

następujący:

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

labels:

app: fileserver

name: fileserver

namespace: default

spec:

replicas: 2

selector:

matchLabels:

app: fileserver

template:

metadata:

labels:

app: fileserver

spec:

containers:

- image: my-repo/static-files:v1-abcde

imagePullPolicy: Always

name: fileserver

terminationMessagePath: /dev/termination-log

terminationMessagePolicy: File

resources:

request:

cpu: "1.0"

memory: "1G"

limits:

cpu: "1.0"

memory: "1G"

dnsPolicy: ClusterFirst

restartPolicy: Always

Skoro nasz replikowany serwer pliku statycznego został przygotowany i uruchomiony,

prawdopodobnie będziesz chciał utworzyć zasób Service działający w charakterze mechanizmu

równoważenia obciążenia.

apiVersion: v1

kind: Service

metadata:

labels:

app: frontend

name: frontend

namespace: default

spec:

ports:

- port: 80

protocol: TCP

targetPort: 80

selector:

app: frontend

sessionAffinity: None

type: ClusterIP

Po zdefiniowaniu zasobu Service dla serwera pliku statycznego zasób Ingress można

rozszerzyć o obsługę nowej ścieżki dostępu. Trzeba w tym miejscu zwrócić uwagę na

konieczność umieszczenia ścieżki / dopiero po ścieżce /api. W przeciwnym razie nastąpi

podciągnięcie do serwera pliku statycznego żądań /api i bezpośrednich żądań API. Oto

zmodyfikowany kod zasobu Ingress.

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: frontend-ingress

spec:

rules:

- http:

paths:

- path: /api

backend:

serviceName: frontend

servicePort: 8080

# UWAGA: ta ścieżka powinna być zdefiniowana w ścieżce /api, w przeciwnym

razie nastąpi przechwytywanie żądań.

- path: /

backend:

serviceName: nginx

servicePort: 80

Parametryzowanie aplikacji za pomocą

menedżera pakietów Helm

Dotychczas koncentrowaliśmy się na kwestiach związanych z wdrożeniem pojedynczego

egzemplarza usługi w pojedynczym serwerze. Jednak w rzeczywistości niemal każda usługa i

każdy zespół zajmujący się obsługą usługi będą ją wdrażały w wielu różnych środowiskach

(nawet jeśli współdzielą one klaster). Jeżeli działasz w pojedynkę i pracujesz nad jedną

aplikacją, prawdopodobnie masz co najmniej wersję programistyczną i wersję produkcyjną

aplikacji, aby móc rozwijać aplikację bez obawy, że ją uszkodzisz po wdrożeniu w środowisku

produkcyjnym. Po uwzględnieniu testów integracji oraz technik CI/CD jest spore

prawdopodobieństwo, że nawet w przypadku pojedynczej usługi i niewielu programistów

wdrożenie będziesz chciał przeprowadzać w co najmniej trzech różnych środowiskach. Może

być ich jeszcze więcej, jeśli rozważysz obsługę awarii na poziomie centrum danych.

W wielu zespołach standardową reakcją na awarię jest po prostu skopiowanie plików z jednego

klastra do innego. Zamiast pojedynczego katalogu frontend/ zwykle mają parę, np. frontendproduction/ i frontend-development/. Takie rozwiązanie jest niebezpieczne, ponieważ stajesz się

odpowiedzialny za zapewnienie synchronizacji między plikami w wymienionych katalogach.

Jeżeli mają one być całkowicie identyczne, to może być bardzo łatwe zadanie. Jednak pewne

różnice między środowiskami programistycznym i produkcyjnym są oczekiwane, co wiąże się z

opracowywaniem nowych funkcjonalności. Dlatego też te różnice powinny być wprowadzone

celowo i pozostawać łatwe do zarządzania.

Inną możliwością jest zastosowanie gałęzi i systemu kontroli wersji, w którym gałęzie

produkcyjna i programistyczna odchodzą od repozytorium centralnego, aby wszelkie różnice

między gałęziami były jasno widoczne. Takie rozwiązanie może być akceptowalne dla

niektórych zespołów. Jednak mechanika przenoszenia między gałęziami jest wymagającym

zadaniem, gdy rozwiązanie (np. stosujący techniki CI/CD system przeprowadzający wdrożenie

do wielu różnych regionów chmury) chcesz wdrażać jednocześnie w różnych środowiskach.

W efekcie większość osób decyduje się na system szablonów. W takim systemie mamy

połączenie szablonów tworzących scentralizowany szkielet konfiguracji aplikacji i parametrów

pozwalających na dostosowanie szablonu do konfiguracji określonego środowiska. W ten

sposób można mieć ogólną, współdzieloną konfigurację i zarazem zachować możliwość łatwego

wprowadzania w niej zmian. Istnieje wiele różnych systemów szablonów przeznaczonych dla

Kubernetes, a najpopularniejszym z nich jest Helm (https://helm.sh/).

Jeśli korzystasz z menedżera pakietów Helm, aplikacja zostaje zapakowana w kolekcję plików

określaną mianem formatu chart (w świecie kontenerów i Kubernetes wiążą się z tym pewne

żarty).

Przygotowanie wspomnianej kolekcji w formacie chart rozpoczyna się od utworzenia pliku

chart.yaml definiującego niezbędne metadane.

apiVersion: v1

appVersion: "1.0"

description: Kolekcja w formacie chart menedżera pakietów Helm dla naszego

serwera frontendu.

name: frontend

version: 0.1.0

Ten plik należy umieścić w katalogu głównym kolekcji w formacie chart (np. frontend/). W

wymienionym katalogu znajduje się podkatalog templates, przeznaczony dla szablonów.

Szablon to w zasadzie nic innego jak plik YAML z wcześniejszych przykładów, przy czym pewne

wartości w pliku są zastąpione odwołaniami do parametrów. Dla przykładu, wyobraź sobie

parametryzowanie liczby replik frontendu. Wcześniej kod źródłowy zasobu Deployment

zawierał następujące polecenia:

...

spec:

replicas: 2

...

W pliku szablonu (frontend-deployment.tmpl) ten fragment wygląda nieco inaczej:

...

spec:

replicas: {{ .replicaCount }}

...

To oznacza, że podczas wdrażania kolekcji w formacie chart ta wartość dla repliki będzie

zastąpiona odpowiednim parametrem. Wspomniane parametry są definiowane w pliku

values.yaml. Będzie istniał jeden taki plik dla każdego środowiska, w którym aplikacja ma

zostać wdrożona. W omawianym przykładzie zawartość pliku wartości jest bardzo prosta:

replicaCount: 2

Po zebraniu wszystkiego w całość omawianą kolekcję w formacie chart można wdrożyć za

pomocą narzędzia helm:

$ helm install ścieżka/dostępu/do/kolekcji/chart --values ścieżka/dostępu/do/

środowiska/values.yaml

W ten sposób aplikacja została sparametryzowana i wdrożona w Kubernetes. Wraz z upływem

czasu liczba tych parametrów będzie się zwiększała, odzwierciedlając w ten sposób

zróżnicowanie środowisk, w których jest wdrażana aplikacja.

Najlepsze praktyki dotyczące wdrożenia

Kubernetes to system o potężnych możliwościach, który może wydawać się skomplikowany.

Jednak podstawowa konfiguracja zapewniająca poprawne działanie aplikacji okaże się prosta, o

ile będziesz się stosować do wymienionych tutaj najlepszych praktyk.

Większość usług powinna być wdrażana w postaci zasobów Deployment. Pozwalają one na

utworzenie identycznych replik, co jest przydatne do zapewniania nadmiarowości i

podczas skalowania.

Wdrożenie można przeprowadzać za pomocą usługi (zasób Service), która właściwie jest

mechanizmem równoważenia obciążenia. Usługa może być udostępniona w klastrze

(rozwiązanie domyślne) lub zewnętrznie. Jeżeli chcesz udostępnić ruch HTTP aplikacji,

możesz skorzystać z kontrolera Ingress w celu dodania np. routingu żądań i obsługi SSL.

Ostatecznie będziesz chciał parametryzować aplikację, aby jej konfiguracja była możliwa

do użycia w różnych środowiskach. Narzędzia pakowania, takie jak menedżer pakietów

Helm (https://helm.sh/), okazują się najlepszym rozwiązaniem do takiej parametryzacji.

Podsumowanie

Wprawdzie aplikacja utworzona w tym rozdziale jest bardzo prosta, ale pozwoliła przedstawić

właściwie wszystkie koncepcje, które są stosowane podczas budowy znacznie większych i

bardziej skomplikowanych aplikacji. Poznanie sposobu, w jaki poszczególne fragmenty łączą się

w całość, oraz sposobu użycia podstawowych komponentów Kubernetes jest kluczem do

sukcesu podczas pracy z tym systemem.

Przygotowanie solidnych podstaw za pomocą systemu kontroli wersji, technik przeglądu kodu i

technik ciągłego wdrażania usługi gwarantuje, że niezależnie od tego, co będziesz tworzyć,

produkt zostanie zbudowany solidnie. Gdy w kolejnych rozdziałach książki będziesz poznawać

bardziej zaawansowane tematy, pamiętaj o przedstawionych tutaj podstawach.

1 Helm to menedżer pakietów dla Kubernetes, chart zaś to format pakietów, w którym kolekcja

plików opisuje zbiór powiązanych ze sobą zasobów Kubernetes — przyp. tłum.

Rozdział 2. Sposób pracy

programisty

Kubernetes zbudowano, aby zapewnić niezawodny sposób działania oprogramowania. Ta

technologia upraszcza więc wdrażanie aplikacji i zarządzanie nimi za pomocą zorientowanego

pod kątem aplikacji API, samodzielnie naprawiających się właściwości, a także użytecznych

narzędzi, które pozwalają np. na przeprowadzenie wdrożenia bez przestoju podczas wydawania

nowej wersji oprogramowania. Wprawdzie wszystkie wymienione możliwości są użyteczne, ale

nie oferują zbyt wiele, aby ułatwić tworzenie aplikacji dla Kubernetes. Co więcej, choć wiele

klastrów zostało zaprojektowanych do uruchamiania aplikacji produkcyjnych, co sprawia, że

programista rzadko ich używa w pracy nad projektem, ale uwzględnienie celów Kubernetes w

trakcie pracy programisty ma znaczenie krytyczne. To najczęściej oznacza posiadanie klastra —

lub przynajmniej jego części — przeznaczonego do używania podczas pracy nad aplikacją.

Przygotowanie takiego klastra mającego na celu ułatwienie procesu tworzenia aplikacji dla

Kubernetes jest ważne, jeśli chcesz osiągnąć sukces w pracy z Kubernetes. Nie powinno ulegać

wątpliwości, że jeśli nie istnieje kod przeznaczony do uruchomienia w klastrze, taki klaster sam

w sobie nie ma zbyt dużej wartości.

Cele

Zanim przejdziemy do omówienia najlepszych praktyk w zakresie tworzenia klastrów

programistycznych, dobrze jest zacząć od zdefiniowania celów dla takich klastrów. Oczywiście

ostatecznym celem jest umożliwienie programistom szybkiego i łatwego tworzenia aplikacji w

Kubernetes. Co to tak naprawdę oznacza w praktyce i jak jest odzwierciedlone w praktycznych

funkcjonalnościach klastra programistycznego?

Użyteczne będzie określenie faz współpracy programisty z klastrem.

Pierwsza faza to tzw. wejście na pokład. Mamy z nią do czynienia, gdy nowy programista

dołącza do zespołu. W trakcie tej fazy programista otrzymuje nazwę użytkownika pozwalającą

na zalogowanie się do klastra, a także zapoznaje się z pierwszym wdrożeniem. Celem tej fazy

jest umożliwienie programiście rozpoczęcia pracy w możliwie krótkim czasie. Powinieneś

zdefiniować współczynnik KPI (ang. key performance indicator) dla tego procesu. Rozsądnym

celem będzie umożliwienie programiście w czasie krótszym niż pół godziny przejścia od niczego

do aplikacji znajdującej się w repozytorium systemu kontroli wersji w stanie określonym jako

HEAD. Za każdym razem, gdy ktoś nowy dołącza do zespołu, dobrze jest sprawdzić, czy ten cel

został osiągnięty.

Druga faza to programowanie. To są codzienne zadania programisty. Celem tej fazy jest

zagwarantowanie dużej szybkości iteracji i debugowania. Programiści muszą szybko i

nieustannie przekazywać kod do klastra. Muszą mieć również możliwość łatwego testowania

kodu i jego debugowania, jeśli nie działa poprawnie. Wartość współczynnika KPI dla tej fazy jest

znacznie trudniejsza do ustalenia, choć można ją oszacować przez pomiar czasu, jaki upłynął do

wykonania żądania aktualizacji (tzw. pull request) w systemie kontroli wersji lub wprowadzenia

zmiany i jej uruchomienia w klastrze. Ewentualnie można przeprowadzać ankiety dotyczące

postrzeganej produktywności użytkownika lub też stosować wszystkie wymienione podejścia.

Powinieneś mieć możliwość mierzenia ogólnej wydajności zespołu.

Trzecia faza to testowanie. Ta faza jest stosowana naprzemiennie z programowaniem i ma na

celu weryfikację kodu przed jego przekazaniem do systemu kontroli wersji i połączeniem z już

istniejącym. Cele dla tej fazy są dwojakie. Po pierwsze, programista powinien mieć możliwość

wykonania wszystkich testów w swoim środowisku, zanim zainicjuje żądanie aktualizacji. Po

drugie, wszystkie testy powinny zostać uruchomione automatycznie, zanim kod zostanie

połączony z kodem istniejącym w repozytorium. Poza wymienionymi celami powinieneś określić

współczynnik KPI dla czasu potrzebnego na wykonanie testów. Gdy projekt stanie się bardziej

skomplikowany, będzie naturalne, że istnieje w nim coraz więcej testów, których wykonywanie

zabiera coraz więcej czasu. W takim przypadku cennym rozwiązaniem może być określenie

mniejszego zestawu testów, które programista może przeprowadzać podczas początkowej

weryfikacji kodu, przed zainicjowaniem żądania aktualizacji. Powinieneś mieć również dość

ściśle zdefiniowany współczynnik KPI związany z tzw. test flakiness, czyli testami zaliczanymi

okazjonalnie (lub nie do końca okazjonalnie). W rozsądnie aktywnym projekcie współczynnik

dla test flakiness wynoszący więcej niż jedno niezaliczenie na tysiąc wykonanych testów będzie

prowadził do tarć między programistami. Trzeba się upewnić, że środowisko klastra nie będzie

umożliwiało powstawania takich testów. Wprawdzie czasami raz zaliczane, a raz niezaliczane

testy występują ze względu na problem w kodzie, ale mogą pojawiać się również na skutek

pewnych zakłóceń w środowisku programistycznym (takich jak wyczerpanie zasobów i

hałaśliwe sąsiedztwo). Należy zagwarantować, że środowisko programistyczne jest pozbawione

wymienionych problemów, co oznacza konieczność pomiaru współczynnika dla test flakiness i

aktywne działanie w celu poprawy jego wartości.

Tworzenie klastra programistycznego

Kiedy ktoś zaczyna zastanawiać się nad rozpoczęciem programowania w Kubernetes, jedna z

pierwszych decyzji do podjęcia dotyczy klastra: czy utworzyć jeden ogromny klaster

programistyczny, czy też przygotować po jednym klastrze dla każdego programisty. Warto w

tym miejscu dodać, że taka decyzja ma sens jedynie w środowisku, w którym dynamiczne

tworzenie klastra jest łatwym zadaniem, czyli np. w publicznej chmurze. W fizycznym

środowisku istnieje prawdopodobieństwo, że jedynym możliwym wyborem będzie utworzenie

pojedynczego, ogromnego klastra.

Jeżeli masz wybór, powinieneś rozważyć wady i zalety każdej z opcji. W przypadku oddzielnego

klastra dla każdego z programistów poważną wadą takiego rozwiązania jest wyraźnie większy

koszt i mniejsza efektywność, a także większa liczba różnych klastrów programistycznych,

którymi trzeba będzie zarządzać. Dodatkowe koszty wiążą się z tym, że prawdopodobnie żaden

z takich klastrów nie będzie w pełni wykorzystany. Co więcej, gdy programiści tworzą różne

klastry, znacznie trudniejsze jest monitorowanie i usuwanie już nieużywanych zasobów.

Natomiast zaletą oddzielnego klastra dla każdego użytkownika jest prostota: każdy programista

może samodzielnie zajmować się obsługą klastra. Ponadto izolacja oznacza, że poszczególni

programiści nie będą mogli tak łatwo utrudniać sobie pracy.

Z drugiej strony pojedynczy klaster programistyczny będzie znacznie efektywniejszy. Jeden

współdzielony klaster prawdopodobnie zapewni obsługę tej samej liczby programistów, a jego

koszt wyniesie co najwyżej jedną trzecią kosztu oddzielnych klastrów dla wszystkich

programistów. Przy tym o wiele łatwiejsze będzie instalowanie usług klastra współdzielonego,

np. w zakresie monitorowania i rejestrowania danych, co z kolei znacznie ułatwia

przygotowanie klastra przyjaznego programistom. Natomiast wadą współdzielonego klastra

programistycznego jest proces zarządzania użytkownikami i to, że programiści mogą wchodzić

sobie w drogę. Ponieważ proces dodawania nowych użytkowników i przestrzeni nazw do

Kubernetes nie jest jeszcze do końca płynny, konieczne będzie aktywowanie procesu w celu

przygotowania zasobów dla nowego członka zespołu. Wprawdzie zarządzanie zasobami i

kontrola dostępu na podstawie roli użytkownika (ang. role-based access control, RBAC) mogą

zmniejszyć prawdopodobieństwo konfliktów między programistami, ale mimo to zawsze istnieje

niebezpieczeństwo, że użytkownik uszkodzi klaster programistyczny przez wykorzystanie zbyt

wielu zasobów, co uniemożliwi działanie innych aplikacji, a tym samym uniemożliwi pracę

pozostałym programistom. Ponadto wciąż trzeba zagwarantować, że programiści nie będą

doprowadzać do wycieków pamięci i zapominać o zwalnianiu zaalokowanych zasobów. Istnieje

łatwiejsze rozwiązanie niż podejście, w którym programiści mogą tworzyć własne klastry.

Wprawdzie oba omówione podejścia są wykonywalne, ale ogólnie zalecamy przygotowanie

pojedynczego, ogromnego klastra dla wszystkich programistów. Pomimo niebezpieczeństwa

związanego z utrudnianiem sobie pracy przez programistów te problemy da się rozwiązać, a

zalety wynikające z ostatecznego kosztu efektywności i możliwości łatwego dodawania do

klastra funkcjonalności są na poziomie całej organizacji większe niż wady związane z

wzajemnym przeszkadzaniem sobie w pracy. Konieczne będzie zainwestowanie w proces

przygotowania zasobów dla nowych programistów, zarządzanie zasobami i zwalnianie

nieużywanych zasobów. Naszym zaleceniem jest wypróbowanie najpierw jednego ogromnego

klastra. Wraz ze zwiększaniem się organizacji (lub jeśli już jest ogromna) można rozważyć

użycie jednego klastra dla zespołu lub grupy (10 do 20 osób) zamiast jednego gigantycznego

klastra dla setek użytkowników. Takie rozwiązanie będzie znacznie łatwiejsze do fakturowania i

zarządzania.

Konfiguracja klastra współdzielonego

przez wielu programistów

Podczas przygotowywania ogromnego klastra podstawowym celem jest umożliwienie, aby

mogło z niego korzystać jednocześnie wielu użytkowników i przy tym sobie nie przeszkadzać.

Oczywistym sposobem na oddzielenie programistów od siebie jest wykorzystanie przestrzeni

nazw w Kubernetes. Wymieniona przestrzeń nazw może działać w charakterze zasięgu dla

wdrożenia usług, aby usługa frontendu jednego programisty nie zakłócała działania usługi

frontendu innego. Przestrzenie nazw są również zasięgiem dla mechanizmu RBAC, co

gwarantuje, że jeden programista nie będzie mógł przypadkowo usunąć pracy drugiego.

Dlatego też we współdzielonym klastrze sensowne jest stosowanie przestrzeni nazw w

charakterze przestrzeni roboczych dla programistów. Proces przygotowywania zasobów dla

użytkowników, a także tworzenia i zabezpieczania przestrzeni nazw zostanie omówiony w

kolejnych punktach.

Przygotowywanie zasobów dla użytkownika

Zanim użytkownika będzie można przypisać do przestrzeni nazw, trzeba umożliwić mu

korzystanie z samego klastra Kubernetes. Dostęp do klastra można zapewnić mu na dwa

sposoby. Pierwszy polega na użyciu uwierzytelniania opartego na certyfikacie w celu

utworzenia nowego certyfikatu dla użytkownika i przekazania mu pliku kubeconfig, który

pozwoli mu zalogować się do klastra. Druga to skonfigurowanie klastra do użycia zewnętrznego

systemu identyfikacji (np. Microsoft Azure Active Directory lub AWS Identity and Access

Management).

Ogólnie rzecz biorąc, użycie zewnętrznego systemu tożsamości jest najlepszą praktyką,

ponieważ wówczas nie trzeba utrzymywać dwóch odmiennych źródeł tożsamości. Jednak w

niektórych sytuacjach takie rozwiązanie jest niemożliwe i trzeba skorzystać z certyfikatów. Na

szczęście oferowanego przez Kubernetes API certyfikatów można użyć do tworzenia

wspomnianych certyfikatów i zarządzania nimi. Zapoznaj się z przedstawionym tutaj procesem

dodawania nowego użytkownika do istniejącego klastra.

Przede wszystkim trzeba wygenerować żądanie podpisania certyfikatu, potrzebne

wygenerowania nowego certyfikatu. Oto prosty program w języku Go, który do tego służy:

do

package main

import (

"crypto/rand"

"crypto/rsa"

"crypto/x509"

"crypto/x509/pkix"

"encoding/asn1"

"encoding/pem"

"os"

)

func main() {

name := os.Args[1]

user := os.Args[2]

key, err := rsa.GenerateKey(rand.Reader, 1024)

if err != nil {

panic(err)

}

keyDer := x509.MarshalPKCS1PrivateKey(key)

keyBlock := pem.Block{

Type: "RSA PRIVATE KEY",

Bytes: keyDer,

}

keyFile, err := os.Create(name + "-key.pem")

if err != nil {

panic(err)

}

pem.Encode(keyFile, &keyBlock)

keyFile.Close()

commonName := user

// Uaktualnij adres e-mail.

emailAddress := "someone@myco.com"

org := "My Co, Inc."

orgUnit := "Widget Farmers"

city := "Seattle"

state := "WA"

country := "US"

subject := pkix.Name{

CommonName: commonName,

Country: []string{country},

Locality: []string{city},

Organization: []string{org},

OrganizationalUnit: []string{orgUnit},

Province: []string{state},

}

asn1, err := asn1.Marshal(subject.ToRDNSequence())

if err != nil {

panic(err)

}

csr := x509.CertificateRequest{

RawSubject: asn1,

EmailAddresses: []string{emailAddress},

SignatureAlgorithm: x509.SHA256WithRSA,

}

bytes, err := x509.CreateCertificateRequest(rand.Reader, &csr, key)

if err != nil {

panic(err)

}

csrFile, err := os.Create(name + ".csr")

if err != nil {

panic(err)

}

pem.Encode(csrFile, &pem.Block{Type: "CERTIFICATE REQUEST", Bytes:bytes})

csrFile.Close()

}

Aby uruchomić ten program, należy wydać następujące polecenie:

$ go run csr-gen.go client <user-name>

Wynikiem działania programu będzie utworzenie plików client-key.pem i client.csr. Następnym

krokiem jest wykonanie przedstawionego poniżej skryptu w celu utworzenia i pobrania nowego

certyfikatu.

#!/bin/bash

csr_name="my-client-csr"

name="${1:-my-user}"

csr="${2}"

cat <<EOF | kubectl create -f apiVersion: certificates.k8s.io/v1beta1

kind: CertificateSigningRequest

metadata:

name: ${csr_name}

spec:

groups:

- system:authenticated

request: $(cat ${csr} | base64 | tr -d '\n')

usages:

- digital signature

- key encipherment

- client auth

EOF

echo

echo "Zatwierdzanie żądania podpisania."

kubectl certificate approve ${csr_name}

echo

echo "Pobieranie certyfikatu."

kubectl get csr ${csr_name} -o jsonpath='{.status.certificate}' \

| base64 --decode > $(basename ${csr} .csr).crt

echo

echo "Porządkowanie."

kubectl delete csr ${csr_name}

echo

echo "Dodaj następujące polecenia do listy 'users' w pliku kubeconfig:"

echo "- name: ${name}"

echo " user:"

echo " client-certificate: ${PWD}/$(basename ${csr} .csr).crt"

echo " client-key: ${PWD}/$(basename ${csr} .csr)-key.pem"

echo

echo "Następnym krokiem jest konfiguracja roli dla tego użytkownika."

Ten skrypt wyświetla ostateczne informacje, które można dodać do pliku kubeconfig w celu

włączenia danego konta użytkownika. Oczywiście użytkownik nie ma uprawnień dostępu, więc

trzeba zastosować opartą na roli kontrolę dostępu w Kubernetes, aby przypisać użytkownikowi

pewne uprawnienia do przestrzeni nazw.

Tworzenie i zabezpieczanie przestrzeni nazw

Pierwszym krokiem w procesie przygotowywania przestrzeni nazw jest jej faktyczne

utworzenie. Można to zrobić za pomocą polecenia kubectl create namespace my-namespace.

Jednak podczas tworzenia przestrzeni nazw zwykle dołącza się do niej mnóstwo metadanych,

np. informacje kontaktowe dla zespołu zajmującego się kompilacją komponentu wdrażanego w

przestrzeni nazw. Ogólnie rzecz biorąc, to jest forma adnotacji: można wygenerować plik YAML

za pomocą systemu szablonów, takiego jak Jinja (https://palletsprojects.com/p/jinja/), bądź też

utworzyć przestrzeń nazw i później dodać adnotację. Spójrz na prosty skrypt, który będzie

wykonywał to zadanie.

ns='my-namespace'

kubectl create namespace ${ns}

kubectl annotate namespace ${ns} annotation_key=annotation_value

Po utworzeniu przestrzeni nazw należy ją zabezpieczyć, co odbywa się przez zagwarantowanie,

że dostęp do niej będzie miał określony użytkownik. W tym celu należy dołączyć rolę do

użytkownika w kontekście przestrzeni nazw. To się odbywa przez utworzenie obiektu

RoleBinding w samej przestrzeni nazw. Oto przykładowy kod wymienionego obiektu:

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: example

namespace: my-namespace

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: edit

subjects:

- apiGroup: rbac.authorization.k8s.io

kind: User

name: myuser

Ostateczne dołączenie roli nastąpi po wydaniu polecenia kubectl create -f rolebinding.yaml. Zwróć uwagę na możliwość wielokrotnego użycia tego skryptu, o ile będziesz

uaktualniał przestrzeń nazw w punkcie dołączania, aby prowadził do odpowiedniej przestrzeni

nazw. Jeżeli zagwarantujesz brak jakiejkolwiek innej dołączanej roli dla użytkownika, wówczas

będziesz miał pewność, że ta przestrzeń nazw to jedyny fragment klastra, do którego dany

użytkownik ma dostęp. Rozsądną praktyką jest również udzielanie uprawnień do odczytu całego

klastra. Dzięki temu programiści mogą widzieć, co robią inni, np. gdy pewne działanie zakłóca

ich pracę. Jednak zachowaj ostrożność w trakcie nadawania takich uprawnień odczytu,

ponieważ oznaczają one także dostęp do zasobów danych poufnych w klastrze. W przypadku

klastra programistycznego nie jest to problemem, skoro wszyscy należą do tej samej

organizacji, a dane poufne są używane jedynie podczas pracy nad aplikacjami. Jeżeli jednak to

jest dla Ciebie źródłem obaw, możesz zastosować znacznie dokładniejszy poziom kontroli

dostępu, który uniemożliwi dostęp do zasobów zawierających dane poufne.

Jeżeli chcesz ograniczyć ilość zasobów używanych przez określoną przestrzeń nazw, możesz

skorzystać z ResourceQuota w celu ograniczenia całkowitej ilości zasobów, które mogą być

użyte przez daną przestrzeń nazw. Przykładowo przedstawiony tutaj fragment kodu powoduje

ograniczenie zasobów przestrzeni nazw do 10 rdzeni i 100 GB pamięci dla zasobów Request i

Limit podów w przestrzeni nazw.

apiVersion: v1

kind: ResourceQuota

metadata:

name: limit-compute

namespace: my-namespace

spec:

hard:

requests.cpu: "10"

requests.memory: 100Gi

limits.cpu: "10"

limits.memory: 100Gi

Zarządzanie przestrzeniami nazw

Skoro się dowiedziałeś, jak przygotować zasoby dla nowego użytkownika i jak utworzyć

przestrzeń nazw przeznaczoną do użycia w charakterze przestrzeni roboczej, pozostało już

tylko przypisanie tej przestrzeni nazw nowego programisty. Podobnie jak w przypadku wielu

innych kwestii, także tu nie istnieje jedno, doskonałe rozwiązanie, lecz raczej dwa podejścia.

Pierwsze polega na nadaniu każdemu użytkownikowi oddzielnej przestrzeni nazw, jako części

procesu przygotowywania dla niego zasobów. Takie podejście jest użyteczne, ponieważ

użytkownik po dodaniu do zespołu zawsze będzie miał przeznaczoną tylko dla niego przestrzeń

roboczą, w ramach której będzie mógł opracowywać aplikacje i zarządzać nimi. Jednak

zdefiniowanie przestrzeni nazw użytkownika jako zbyt trwałej zachęca go do pozostawiania w

niej różnych zasobów po zakończeniu pracy z nimi, więc zbieranie i usuwanie nieużytków oraz

ocena pozostałych zasobów stają się znacznie bardziej skomplikowane. Alternatywne podejście

polega na tymczasowym utworzeniu i przypisaniu przestrzeni nazw w ramach ograniczenia TTL

(ang. time to live). Dzięki temu programista będzie traktował zasoby klastra jako tymczasowe,

co ułatwi opracowanie automatyzacji odpowiedzialnej za usuwanie całych przestrzeni nazw po

wygaśnięciu TTL.

W takim modelu, gdy programista rozpoczyna pracę nad nowym projektem, używa narzędzia do

alokacji nowej przestrzeni nazw dla danego projektu. Podczas tworzenia przestrzeni nazw

dodawana jest do niej pewna ilość metadanych potrzebnych w procesie zarządzania

przestrzeniami nazw. Oczywiście te metadane zawierają również wartość TTL dla przestrzeni

nazw, dane programisty, który został do niej przypisany, zasoby przeznaczone dla danej

przestrzeni nazw (np. procesor i pamięć), a także informacje o zespole i przeznaczeniu